internet - search results

If you're not happy with the results, please do another search

Ya te puedes tratar la adicción a Facebook

Efectivamente, ya existe una clínica que te ayuda a controlar tu adicción a la red social más grande del mundo. ‘‘El objetivo de la clínica es el de contener el malestar de abstinencia de la red y proporcionar asistencia psicológica’‘, explicó el doctor Federico Tonioni.

La susodicha clínica se encuentra en Italia dentro del Policlínico Gemelli de Roma, según nos informa en Informativo de Tecnología. Este centro se dedica exclusivamente a tratar esta patología a unas 20 personas, en su mayor parte hombres y muy jóvenes.

Sin embargo, los fundadores de esta clínica consideran “insuficientes” la capacidad de esta clínica para dar cabida a una creciente oleada de internautas que no saben distinguir entre el mundo virtual de Facebook y la realidad.

El tratamiento de la adicción a Facebook se realiza en tres pasos: un diagnóstico inicial para encontrar la adicción, reuniones sucesivas de detección de la psicopatología del paciente (con posible uso de psicofármacos) y la participación en grupos de rehabilitación que estimulen las relaciones interpersonales reales.

No obstante, este no es el único centro que hay en el mundo que se dedica a curar la adicción de las nuevas tecnologías. En Turín y China existen otros centros de similares característica que se encargan de desengachar a los usuarios de Internet.

Visto en Muy Internet

Wifi Gratis

Como otro gesto de colaboración con las víctimas del terremoto del 27 de febrero pasado, que aún siguen con problemas para comunicarse, la empresa Telmex dispuso de varios puntos para poder conectarse gratuitamente a Internet vía Wi-Fi en las ciudades de Talca, Constitución y Concepción.

La empresa informó que la señal será emitida por cinco antenas, lo que permitirá a los usuarios llegar con sus computadores o celuares y acceder a la conexión inalámbrica de forma absolutamente gratuita.

Las zonas “iluminadas” son las siguientes:

– En Constitución, dentro del área delimitada por las calles Av. Enrique Mac Iver- Avda. Santa María y Rengifo.

– En Concepción, entre las calles Caupolicán, Av. Paicaví, Víctor Lamas y Av. Los Carreras.

– En Talca, entre las calles 2 Norte, 6 Oriente, 1 Poniente y 5 Sur.

Quienes se encuentren dentro de estas áreas podrán acceder a internet detectando en sus equipos la señal inalámbrica “Telmex Chile Gratis“.

Esta medida se suma a otras implementadas por la empresa anteriormente como la liberación de los primeros cinco minutos de llamadas larga distancia nacional desde y hacia las VII y VIII Región a través de su carrier.

Visto en Emol

Buscaron tambien:

Condenan a jefes de Google por publicación de video

Tribunal italiano condenó a tres directivos de la empresa por publicar video en el que se ofende a un joven con síndrome de Down.

Un tribunal italiano condenó a tres ejecutivos de Google por publicar un video donde unos jóvenes maltratan a un adolescente con síndrome de Down.

Los empleados de la empresa enfrentaban un juicio por acusaciones de violar leyes italianas al publicar el polémico video.

El juez Oscar Maggi desestimó las acusaciones de difamación pero los condenó por violación del derecho a la privacidad.

Los tres recibieron condenas de seis meses de cárcel en suspenso, aunque no tendrán que ir tras las rejas según la legislación italiana. Un cuarto dirigente fue absuelto.

El corresponsal de la BBC en Italia, Duncan Kennedy, explica que una organización de defensa de las personas con síndrome de Down había demandado a la empresa por violar la intimidad del joven. Pero Google respondió que no puede hacerse responsable de los contenidos que otros publican y dijo que es como si una persona demandara al servicio postal por recibir cartas ofensivas.

LIBERTAD V/S PRIVACIDAD

Se cree que el veredicto podría sentar precedentes en el comportamiento de los proveedores de internet en el mundo.

Google señaló que el juicio representa una amenaza para la libertad en la red y que visualizar todos los contenidos antes de publicarlos es imposible.

El video en cuestión había sido publicado en el servicio Google Videos en 2006, poco antes de que la empresa estadounidense adquiriera el portal YouTube.

Los fiscales alegaron que Google violó las leyes italianas al no pedir el consentimiento de las partes involucradas antes de difundir las imágenes.

Los abogados de Google dicen que el video fue sacado de la página apenas se dieron cuenta y que la empresa dio información sobre quién lo había puesto online.

El video en cuestión mostraba cómo un joven con síndrome de Down era insultado y víctima de burlas por parte de sus compañeros en un centro de formación de la ciudad italiana de Turín. La grabación había sido además incluida en la categoría de videos más divertidos y había llegado al puesto 29 de los más vistos.

Como consecuencia del episodio, cuatro alumnos fueron expulsados del instituto.

Visto en La Tercera

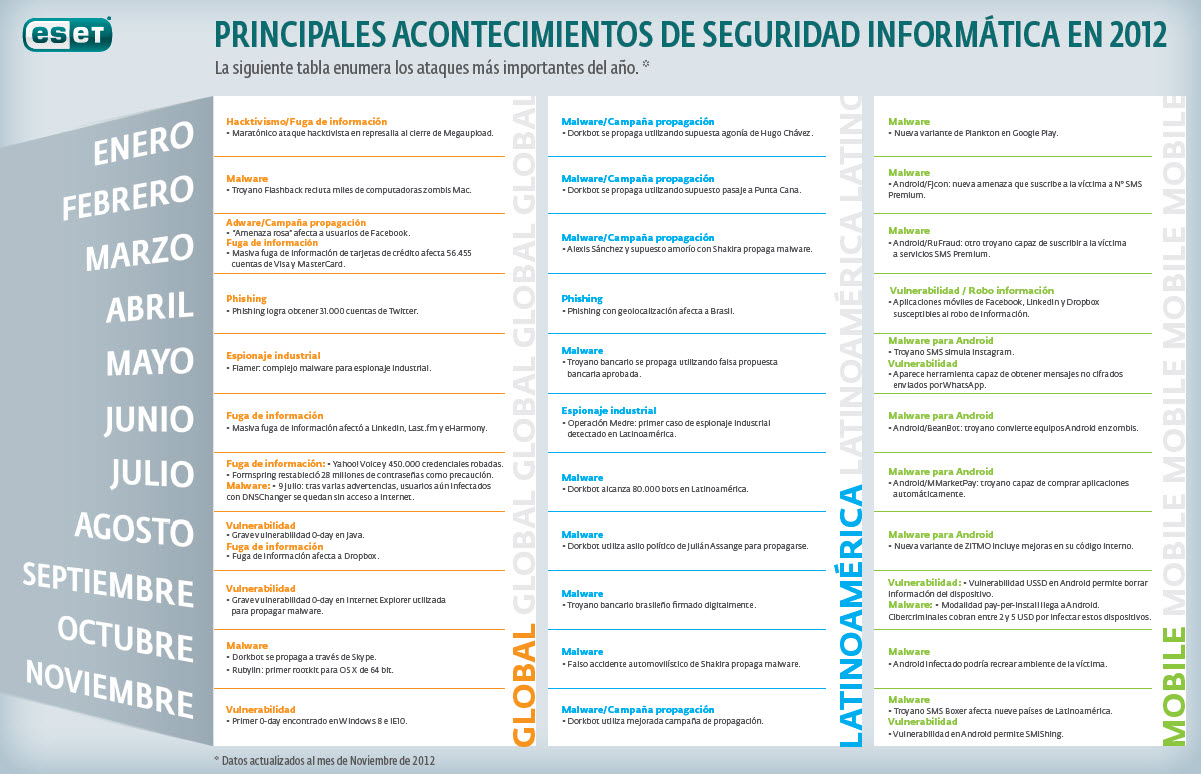

Seguridad de la información

En el informe se citan varias historias basadas en eventos auténticos, que ilustran las implicancias del “mundo real” en los retos actuales de la seguridad.

En un caso, cientos de altos funcionarios federales y directivos de empresas, visitaron un sitio político infectado, y todas sus computadoras se convirtieron en máquinas zombis. Keylogers instalados en sus equipos, capturaron nombres de usuario y contraseñas de sus cuentas bancarias y otra información financiera, y enviaron todo ello a cibercriminales de varios países. Mucho dinero y datos críticos fueron perdidos.

En otro caso, un adolescente simplemente visitó una página de Internet con una versión no actualizada de un reproductor multimedia. Un video se abrió apenas el joven entró al sitio, mientras un keylogger (capturador de la salida del teclado), se instalaba en su equipo sin su conocimiento. Es el mismo equipo que su padre utiliza para manejar sus cuenta bancarias en línea. La cuenta fue literalmente vaciada por los atacantes. A pesar de que el banco más tarde compensara en parte las pérdidas, los investigadores descubrieron que el dinero fue a parar a un grupo de terroristas suicidas en medio oriente.

En un tercer caso, una aplicación hecha a medida tenía un error de programación que permitía a los delincuentes acceder a los registros privados de los pacientes de un hospital. El hospital fue extorsionado a pagar una suma de dinero para evitar que los registros se hicieran públicos en Internet.

Estas y otras historias ilustran el informe del SANS que intenta mostrar el panorama actual de la seguridad informática. El mismo es la creación de un trabajo colectivo de cuarenta y tres expertos en seguridad, pertenecientes a gobiernos, industrias e instituciones académicas de varios países.

En el panorama que presenta el informe del SANS, se destacan los continuos asaltos de programas automatizados en busca de vulnerabilidades. De hecho, el Internet Storm Center, el sistema de alertas tempranas del SANS, informó que “una computadora recién conectada a Internet, puede ser atacada de inmediato, y no llegará a sobrevivir más de cinco minutos si no fue debidamente configurada o protegida antes de conectarse.”

seguridad informática

Alan Paller, director de investigaciones del SANS, dice que muchas aplicaciones web personalizadas, son programadas sin tener en cuenta los requisitos de seguridad necesarios. “Hasta que los colegios que enseñan programación y las empresas que contratan a los programadores, garanticen que los desarrolladores dominan la codificación segura“, dijo, “seguirán existiendo importantes vulnerabilidades en casi la mitad de todas las aplicaciones web.”

El informe sugiere algunas formas de defensas acerca de las aplicaciones que pueden permitir que un sitio pueda comprometer la información de las computadoras o infectarlas. La mejor defensa es la utilización de cortafuegos y antivirus, educar a los usuarios para sensibilizarlos en cuestiones de seguridad, y entrenar al personal de las empresas para detectar síntomas como un aumento imprevisto en el tráfico de la red.

Otros riesgos señalados en el informe, incluyen dispositivos no autorizados (memorias USB por ejemplo), y el uso indebido de programas de intercambio de archivos. El informe indica que en general, las mejores prácticas deben incluir la configuración de los sistemas para prevenir la instalación no autorizada de software, el uso de proxys, el cifrado de los datos sensibles, y la prueba exhaustiva en un ambiente controlado, de cualquier software antes de ser instalado en la red de la compañía.

Visto en la Flecha

seguridad informática

Un punto crítico en la era tecnológica que estamos viviendo es proteger la información, lo que llamamos “Seguridad informática“.

La seguridad informática es muy importante a la hora de proteger el equipo computacional y aún más importante la información. Un gran porcentaje de los usuarios de sistemas informáticos no le toma el peso a este aspecto, ya sea por desconocimiento, falta de interés o mal asesoramiento profesional.

Con el avance de las tecnologías en especial del Internet se hace indispensable tomar algunas precauciones a la hora de sumergirnos en este mundo, como por ejemplo mantener siempre actualizado el sistema operativo y las herramientas de detección de software malicioso (Virus, troyanos, malware en general).

Vivimos en tiempos donde el comercio electrónico se ha masificado, lo que ha aumentado la cantidad de fraudes y delitos informáticos, es necesario proteger la información, para mantenerla íntegra, disponible y confidencial. Según estadísticas más del 50% de las personas sigue usando contraseñas poco seguras al momento de utilizar servicios en Internet.

Seguridad informática en las empresas

El impacto de la seguridad informática en las empresas es de máxima importancia. Sufrir un ataque externo o interno podría ser catastrófico en cuanto a productividad y pérdida de la confianza de los clientes. Es necesario reducir las vulnerabilidades y asegurarse que el acceso a la información sea solo por personas autorizadas.

En cuanto a la pequeña y mediana empresa, las condiciones de seguridad que poseen son básicas o no existen. Ahí es donde la capacitación juega un papel fundamental.

Como consejo, lo principal es informarse y asesorarse por profesionales de las tecnologías de la información. Hay que tener en cuenta que hay alternativas gratuitas o de pago para proteger la información, la decisión entre una u otra dependerá mayormente de cómo se adapte a la realidad de la empresa.

Arturo

Webfecto.com

Google quiere ser el dueño de la banda ancha

Google quiere ser el dueño de la banda ancha

El motor de búsqueda por internet Google se prepara para convertirse en proveedor de infraestructura al ofrecer banda ancha ultrarrápida a miles de usuarios en Estados Unidos.

La empresa construirá una red de fibra óptica que en su fase experimental brindará velocidades de hasta 1GB por segundo a un máximo de 500.000 personas.

Google anunció que con su incursión en este nuevo rubro competirá en precio con otros proveedores de banda ancha que brindan velocidades menores.

La compañía dijo que durante el período de prueba la empresa se centrará en promover aplicaciones novedosas, las cuales funcionarían a su nivel óptimo debido al aprovechamiento de las altas velocidades de la red.

“Planeamos construir y poner a prueba una red de banda ancha ultrarrápida en un número limitado de lugares experimentales en Estados Unidos”, anunció el gigante de internet a través de su blog.

Más Rapido

“Ofreceremos velocidades en la red más de 100 veces superiores a las que tienen acceso la mayoría de los estadounidenses actualmente. Calculamos que el servicio brindará un precio competitivo a entre 50.000 y 500.000 personas”, agregó la compañía.

Google ya cuenta con una red de fibra óptica que conecta sus centros de datos, acelera la búsqueda en internet y disminuye los costos de bajar videos en el sitio por internet YouTube.

La compañía con sede en Mountain View, California, estudia ir más allá y para ello dará el próximo paso con este nuevo rubro que consistirá en poner esa red a disposición directa de los hogares de sus usuarios.

La red podrá ser utilizada por cualquier proveedor de servicios y Google ha pedido a las partes interesadas ““desde gobiernos locales hasta miembros del público- que se suscriban al plan.

La oferta es parte de la expansión de Google en su intento por controlar todos los aspectos vinculados a la experiencia que implica para los usuarios utilizar internet.

El especialista en temas tecnológicos de BBC Mundo, David Cuen, señaló que Google busca que la infraestructura no sea un obstáculo sino un vehículo para sus productos, servicios y aplicaciones. Al instalar conexiones de fibra óptica quiere mostrar que se le puede sacar aún más provecho a internet.

No es la primera vez que Google pasa del software al hardware. Lo hizo primero con la telefonía celular, no porque quisiera convertirse en el fabricante líder de teléfonos, sino porque quiere que sus productos -buscador, publicidad, correo, etc.- sean parte fundamental de los teléfonos del futuro. Ahora es posible que busquen que la gente desarrolle aplicaciones multimedia dentro de sus propios productos, lo que sólo puede hacerse en una red de banda ancha más veloz, agregó.

Los tentáculos de la empresa también involucran la producción de energía renovable.

Hace poco creó la subsidiaria Google Energy, solicitó permiso a las autoridades estadounidenses para vender y comprar energía renovable como cualquier otra empresa de servicio público.

Aunque Google afirmó que no tiene planes concretos de convertirse en comercializador de energía, sí dejó claro que busca contar con la flexibilidad de comprar y vender energía renovable en caso de ésta se convierta en parte del portafolio de la compañía.

Visto en La Tercera

Actualización Microsoft

El paquete de actualizaciones de febrero que lanzará Microsoft el próximo martes permitirá solucionar varios fallos de Windows y Office, incluyendo cinco fallos críticos para la seguridad del equipo, otros siete importantes y solo uno que considera moderado.

Según los expertos, febrero es el mes preferido por Microsoft para lanzar sus parches más llamativos y numerosos. En el caso de Office, las actualizaciones están dirigidas para las versiones antiguas, así que Office 2010 no necesitará actualizaciones de momento. Por el contrario, los usuarios de Mac no tendrán que actualizar sus versiones de Office 2007 y 2008 puesto que su nivel de seguridad era y es bastante superior con respecto a las antiguas versiones para Windows.

La idea de Microsoft es que los usuarios actualicen sus equipos a las versiones más recientes –Windows 7 y Office 2010– porque, según la compañía, son más seguras y ofrecen una mayor protección contra ataques externos.

No obstante, gracias a varios expertos de la red, se ha descubierto que las nuevas actualizaciones corrigen errores de seguridad que también se dan en Windows 7, Vista y Windows Server 2008. Fallos, que si son aprovechados, podrían permitir a cualquier hacker entrar al sistema por el kernel de Windows y hacerse con todos los privilegios de usuario, según explicaban en enero investigadores de Microsoft.

Además, estos parches no arreglan un fallo de Internet Explorer bajo Windows XP y anteriores, que facilitaría el acceso de desconocidos al disco duro del equipo y tampoco soluciona un problema similar en el protocolo Server Message Block, que fue detectado por Microsoft, en un boletín de seguridad de noviembre.

Visto en PC World

Buscaron tambien:

gestión de la información

La entrada del nuevo año traerá consigo un aumento en el volumen de la gestión de archivos y registros por parte de empresas privadas y organismos públicos, junto con una importancia creciente de nuevos soportes y herramientas. Iron Mountain, líder mundial en gestión y protección de la información, ha señalado las tendencias que marcarán el ritmo en el año que comienza

1. El uso del correo electrónico continuará creciendo.

Las empresas están empezando a reconocer el correo electrónico como una forma de comunicación formal que requiere una correcta gestión, tal y como sí se tratara de información física. Un reciente informe elaborado por Radicati calcula que para 2013 los usuarios corporativos enviarán y recibirán una media de 219 correos electrónicos durante su jornada laboral, lo que equivaldrá a una media de 31 megabytes de datos por persona al día.

Esta situación impulsará la necesidad de implementar sistemas de gestión de archivos de correo que faciliten localizar la información, clasificar los documentos y aplicar medidas más eficaces de retención.

2. La protección de datos estará cada vez más regulada

Las regulaciones relacionadas con la gestión de la información en materia de protección de datos continuarán creciendo en 2010, y especialmente las relacionadas con todo lo referente a los datos de carácter personal. Esto hace necesaria una mayor evaluación de riesgos en este terreno por parte de las empresas, que deberían incluso considerar la imposición de sanciones a las personas que no cumplan con la legislación. Cada vez más, los Responsables de Gestión de la Información, Responsables de Calidad y Responsables Legales deberán trabajar de forma conjunta para desarrollar un sistema de gestión de la información sin riesgos y con un coste adecuado.

3. Los Directores de Archivos como Gestores Globales de Información

La información corporativa está sujeta a un número creciente de regulaciones en diferentes lugares del mundo; ello provocará que el papel del Director de Archivos de una compañía cambie para adaptarse a los requerimientos legales y reducir los riesgos, lo que le convertirá de facto en Manager Global de Información. Como tal, deberá trabajar estrechamente con el Departamento Legal, con el Responsable de Gestión de la Información, con el Departamento de Calidad y el Departamento Financiero para controlar todos los aspectos de gestión de la información en cada país.

4. La Nube se convertirá en el mayor archivo del mundo

Los beneficios de albergar información en servidores externos -lo que se conoce popularmente como Cloud Computing- continuarán haciéndose evidentes: al necesitar menos recursos físicos como instalaciones y hardware, y menores inversiones en IT, son una opción cada vez más atractiva para el archivo de documentos, copias de seguridad o toda la gestión de información en soporte electrónico. El único aspecto que sigue frenando su popularización son las dudas en el terreno de la seguridad, lo que convierte en crucial que las empresas seleccionen a un proveedor fiable y con experiencia en este terreno.

5. La externalización no se detiene

La estrategia de externalización que están utilizando hoy en día las compañías en todos los mercados verticales, se revela como una herramienta eficaz para lograr una reducción de costes y una correcta gestión documental. Según datos de la consultora IDC, el volumen mundial de datos digitales alcanzará este año los 998.000 millones de gigabytes. Este incremento se debe principalmente a los nuevos requerimientos legales y al continuo crecimiento del volumen de información que se maneja a diario.

6. La atención sanitaria también pasará a la Nube

El año 2010 va a ser el escenario de un crecimiento notable en la información sanitaria, particularmente en campos como la Historia Clínica Electrónica, las pruebas médicas y las reclamaciones de los pacientes. Actualmente, este sector hace frente al almacenamiento, acceso, normativa legal e infraestructuras combinado con una limitación en costes para afrontar estos retos. La solución a este crecimiento se puede encontrar en el almacenamiento en la Nube, solución que continúa ganando popularidad en otros sectores. El almacenamiento en la Nube aprovecha el poder de Internet y se posiciona como una de las soluciones más plausibles para los grandes volúmenes de información. Se espera también que su uso traiga aparejadas nuevas vías en el almacenamiento, acceso y gestión de los datos.

Visto en La Flecha

Buscaron tambien:

Google Chrome 4

Google presentó ayer una nueva versión de su navegador de Internet, llamado Chrome, el cual ya registra más de 1.500 extensiones para diferentes propósitos, que van desde revisar la cuenta de correo electrónico hasta herramientas para desarrolladores.

La actualización a esta nueva versión estable se realizará de forma automática para los usuarios de Windows durante la próxima semana, cuando también estará disponible para su descarga, según se anunció en el blog oficial del navegador.

Otra de las nuevas características de Chrome 4.0 es que en términos de velocidad es un 42% superior a la versión 3.0 según los tests Mozilla Dromaeo DOM Core Tests, mientras que si se compara con la versión inicial 1.0, el rendimiento se multiplica por cuatro.

La nueva versión también incluye sincronización de favoritos, característica que permitirá poder trabajar desde cualquier computador y acceder a toda la información de los marcadores que se utiliza en el propio gracias a una cuenta en Google.

Finalmente los desarrolladores también podrán sacar provecho de este navegador, ya que se incorporaron algunas APIs para trabajar sobre HTML5 (LocalStorage, Database API, WebSockets, entre otras).

Visto en Emol

No hay caso. Por más que diferentes estudios, expertos y casos reales recomienden usar claves más seguras en Internet, una preocupante proporción siguen siendo las mismas de siempre, con los evidentes problemas que esto puede acarrerar.

Un estudio de la consultora Imperva que analizó el hackeo que dejó al descubierto las claves de los usuarios. Tras el análisis de éstas, los resultados fueron sorprendentes y decepcionantes: la más común es “123456”.

Pero la lista continúa. La segunda más utilizada es “12345”, después “123456789”, y por último la clásica €œpassword”.

El informe concluye que cerca del 50% de los usuarios usaron claves de baja seguridad, incluyendo nombres, palabras del diccionario y otras como letras que están juntas en el teclado (como zxcvb).

Sólo un 0.2% de los usuarios tienen una contraseña considerada segura, de ocho o más caracteres, con una mezcla de caracteres especiales, números, o minúsculas y mayúsculas, como destacó el sitio TechCrunch.

De acuerdo a Imperva, las contraseñas débiles le hacen muy fácil el trabajo a los hackers, que con un pequeño esfuerzo pueden acceder fácilmente a las cuentas. Porque este tipo de claves no se usan sólo en sitios más triviales como las redes sociales, sino que también para los bancos, por ejemplo.

Porque además, los usuarios tienen la misma clave para diferentes servicios, por lo que basta con enterarse de una clave para poder acceder a distintos sitios, y como recuerda TechCrunch, eso causó el hackeo de los documentos de Twitter el año pasado, donde el hacker sólo tuvo que descubrir la clave en Gmail de un empleado, para luego acceder a toda la información confidencial de la empresa.

Visto en Emol

Prev1...161718...28Next

Prev1...161718...28Next  Page 17 of 28

Page 17 of 28