seguridad - search results

If you're not happy with the results, please do another search

Hoy por hoy es una utopía que Linux vaya a desbancar al resto de sistemas operativos, especialmente a Windows, pero ¿te has preguntado alguna vez qué sucedería si se llegara a producir la adopción generalizada de Linux?

Hoy por hoy es una utopía que Linux vaya a desbancar al resto de sistemas operativos, especialmente a Windows, pero ¿te has preguntado alguna vez qué sucedería si se llegara a producir la adopción generalizada de Linux?

Partimos de la base de que tan sólo son conjeturas y de que los analistas no confían actualmente en que Linux pueda llegar a ser el sistema operativo más usado, pero en PCWorld han sacado su bola de cristal para predecir cuáles serían los cambios que supondría que ese 1% de usuarios de Linux se convirtiera en el 100%.

En primer lugar, “el monocultivo de Windows desaparecería y sería reemplazado por una diversidad de distribuciones de Linux”, señala Katherine Noyes.

También supondría un duro golpe para la industria del malware, ya que les pondría muy difíciles las cosas a sus creadores porque “en lugar de tener un sólo objetivo grande, fácil y lento de movimientos, tendrían que matar a 100 pájaros de un tiro”

En segundo lugar, un mundo dominado por Linux significaría también un cambio en las soluciones de seguridad para PC, ya que teniendo en cuenta la apertura del código y las ventajas en seguridad de Linux, “lo que ahora es una industria de seguridad colosalmente grande no sería capaz de sostenerse a sí misma en una escala tan masiva”.

También predicen que se reduciría el tiempo de inactividad. “Entre los problemas de malware y otros elementos (…), Windows tiende a estar asociado con un montón de tiempo de inactividad no planificado”, mientras que Linux “es bien conocido por su fiabilidad”.

La cuarta ventaja se refiere directamente al bolsillo, ya que la adopción generalizada de Linux supondría importantes ahorros a nivel mundial, ya que “empresas e individuos en todo el mundo dejarán de tener que pagar tarifas desorbitadas por licencias y otros costes”.

Y por último, un mundo con Linux supondría un mejor software, según explica Katherine Noyes, ya que los usuarios “tendría en su mano la configuración del software que utilizan” y podrían sugerir y aportar mejoras.

Visto en The Inquirer

El equipo del Laboratorio de la empresa desarrolladora del multipremiado antivirus ESET NOD32 advierte sobre el afianzamiento del malware dinámico como tendencia para el 2011, apoyado en el creciente desarrollo de las botnet.

El equipo del Laboratorio de la empresa desarrolladora del multipremiado antivirus ESET NOD32 advierte sobre el afianzamiento del malware dinámico como tendencia para el 2011, apoyado en el creciente desarrollo de las botnet.

Las redes botnet serán protagonistas durante el próximo año, afirmando la tendencia observada durante el 2010: mayor cantidad de malware del tipo bot, aumento en la cantidad de redes activas y más cantidad de equipos zombis, según el informe “Tendencias 2011: las botnet y el malware dinámico” de la compañía líder en seguridad informática ESET.

Asimismo, el monto recaudado por los administradores de este tipo de redes también aumentará y se verán innovaciones en las tecnologías de las mismas. Esta tendencia incrementará el trabajo enfocado a dar de baja este tipo de redes delictivas. Asimismo, el monto recaudado por los administradores de este tipo de redes también aumentará y se verán innovaciones en las tecnologías de las mismas. Esta tendencia incrementará el trabajo enfocado a dar de baja este tipo de redes delictivas.

Entre las principales, se pueden mencionar:

Auge de las botnet y el fin del malware estático

Los códigos maliciosos dinámicos son aquellos que primero infectan el sistema y luego, a través de algún acceso remoto al equipo afectado, permiten al atacante realizar diversas tareas mientras el equipo no sea desinfectado.

Las botnet son la confirmación del malware dinámico en conjunto con el negocio delictivo: los equipos zombis pueden ser utilizados en cualquier momento por el administrador de la red para realizar diversas tareas que por lo general están asociadas a diversos delitos informáticos, tales como el robo de información, ataques a través de Internet o envío de spam, entre otros.

Según los datos relevados por el Laboratorio de ESET Latinoamérica, a noviembre de 2010 fueron detectadas unas cinco mil quinientas botnet (habiendo llegado a seis mil en meses como mayo o julio de 2010), contra los pocos más de cuatro mil de finales del año anterior. Según esta tendencia se estima que durante el 2011 la mayoría de los usuarios infectados con cualquier tipo de código malicioso podrían formar parte de una botnet.

El principal motivo del auge de las botnet y de la gran cantidad de usuarios infectados está basado en que el atacante obtiene un importante rédito económico por los servicios delictivos brindados por estas redes. Además, necesitan de muy poco dinero inicial para armar este tipo de red delictiva ya que pueden obtener paneles de administración y malware del tipo bot a muy bajo costo.

Desarrollo de malware multiplataforma

Como alternativa más rentable para los desarrolladores de malware aparece la creación de códigos maliciosos multi-plataforma, archivos que pueden afectar a diversas plataformas con un mismo fin, o bajo un mismo modelo de infección. Un ejemplo de esta tendencia se observó a finales de año, con la aparición de una nueva variante del troyano Koobface, conocida como Boonana e identificada por ESET con la firma Java/Boonana.A. Esto implicó entonces la primer versión multi-plataforma de este troyano que está en actividad desde finales de 2008 y que, dos años después de su creación, expande su propagación más allá de sistemas Windows, infectado también sistemas Linux y Mac OS.

También esta tendencia se observó a principio de año con un experimento realizado para crear botnet en plataformas móviles con iPhone y Android, obteniendo más de ocho mil dispositivos afectados.

BlackHat SEO Social

Hoy en día prácticamente ningún usuario de Internet pasa un día completo sin realizar una búsqueda en la web o utilizar alguna red social. Durante el próximo año este dato tampoco será ignorado por los atacantes, por lo que se estima que incorporen nuevas tendencias basadas en los ataques ya existentes para estos dos servicios.

En materia de buscadores, se espera una optimización en los tiempos de posicionamiento, es decir, una menor demora entre la ocurrencia del evento usado como anzuelo y su ubicación en resultados envenenados por medio de técnicas de BlackHat SEO.

Las redes sociales, por su parte, ganan cada vez más usuarios, por lo que es esperable que continúen siendo usadas como medio de propagación de malware, phishing, spam o scam entre otras amenazas informáticas.

A su vez, es probable que el hecho de que los buscadores comiencen a mostrar no sólo sitios web, sino también resultados en redes sociales origine una nueva forma de BlackHat SEO basada en las redes sociales, donde ya no es necesario para los atacantes la creación de sitios web envenenados sino que pueden hacerlo directamente con perfiles falsos generando contenidos que enlacen a malware.

“El malware dinámico apoyado en el crecimiento de las botnet, el desarrollo de malware multiplataforma y el BlackHat SEO Social serán noticias en el 2011. Sin embargo, también continuarán consolidándose ataques informáticos que ya casi son clásicos y que se sumarán a las tendencias mencionadas: la explotación de vulnerabilidades, el uso de técnicas de Ingeniería Social, la apropiación de datos privados de los usuarios por medio de las redes sociales y el desarrollo de malware desde Latinoamérica”, aseguró Federico Pacheco, Gerente de Educación e Investigación de ESET Latinoamérica.

Visto en CXO Community

Intel - Imagen obtenida desde http://www.flickr.com/photos/joshb/

Intel – Imagen obtenida desde http://www.flickr.com/photos/joshb/

Intel prevé para 2011 que las tecnologías serán más inteligentes, más poderosas y más útiles. A continuación se presentan las predicciones de la compañía sobre algunas de estas tendencias:

La experiencia de la televisión inteligente se hace realidad

Espere que un gran número de empresas de televisión, cable y otras compañías de electrónica de consumo se unan a Sony, Logitech, Boxee y Cisco para entrar en los mercados de televisión y video inteligentes. A finales de 2011 estas empresas deben ser capaces de medir la aceptación de la televisión inteligente por parte del consumidor. ¿Funcionará o se apagará el interés?

Ventas aún mayores de laptops

Las ventas de laptops continuarán con un fuerte crecimiento gracias a los próximos procesadores Intel® Core™ 2011, que añaden una multitud de nuevas características de alta definición (HD) y relacionadas con los gráficos dirigidas a los consumidores, incluida la transmisión inalámbrica de contenidos para su visualización en televisores. Con capacidades de clase empresarial mejoradas, como la Intel Anti-Theft Technology, el gasto de TI en servidores, PCs y laptops también debe aumentar.

Tabletmanía, “Hibrid-ización”

El cómputo tablet, en una multitud de formatos y sistemas operativos, inundará el mercado. Espere ver también productos híbridos tablet/laptop, como un prototipo de Dell basado en la tecnología Intel que se presentará en el Intel Developer Forum; o el nuevo MacBook Air de 11 pulgadas, que tiene la apariencia y se siente como una combinación de lo mejor de los laptops, con lo mejor de los tablets.

La Ley de Moore prospera

Las innovaciones y las nuevas técnicas de fabricación siguen desafiando a los escépticos que afirman que la Ley de Moore está muerta. Esto significa que, en los próximos años, a medida que miles de millones de nuevos dispositivos adquieren capacidades de cómputo y conectividad a Internet, tendrán un desempeño significativamente mayor, con más características embebidas en el silicio, mientras que también se reducirá drásticamente el consumo de energía y se extenderá la duración de la batería.

Mayor seguridad

A medida que los requisitos de TI cambian rápidamente debido a un panorama de amenazas cada vez más complejo y a nuevos modelos de uso, incluyendo nubes y muchos dispositivos de electrónica de consumo (CE) que se conectarán a Internet, la seguridad seguirá siendo una de las máximas prioridades de la industria de TI. Durante el próximo año, la industria se centrará en las capacidades fundamentales para la protección de las infraestructuras y en el mantenimiento de los secretos, tanto personales como de negocios. Los procesadores Intel® Core™ vPro™, la adquisición de McAfee por parte de Intel y numerosos proyectos dentro de y en torno a los chips de silicio de Intel tendrán un papel muy importante al respecto.

Los PCs y los dispositivos inteligentes ganan sentidos: cómputo perceptual y consciente del contexto

Los consumidores se enamorarán de la primera ola de computadoras conscientes del contexto o perceptuales, que apalancarán las tecnologías de sensor hard y soft. Por ejemplo, un dispositivo móvil llamado Personal Vacation Assistant utiliza tecnologías de cómputo conscientes del contexto para ayudarle a sacar el máximo provecho de la experiencia de viaje. El dispositivo portátil utiliza “sensores hard” (cámaras que reconocen los objetos e información basada en GPS) y “sensores soft” (información que los viajeros introducen en el dispositivo, tal como preferencias de cocina y de agenda) para realizar recomendaciones en el lugar de paisajes que ver, lugares para comer y más.

Los consumidores comprarán marcas de confianza en una economía incierta

La incertidumbre económica seguirá siendo la fuerza motriz de una forma más ponderada de consumo y toma de decisiones por parte de los consumidores. La mayoría de los consumidores lo pensará dos veces a la hora de comprar. A pesar de este estado permanente de incertidumbre, los consumidores probablemente regresarán a las marcas conocidas, porque representan una inversión de confianza y ofrecen calidad comprobada.

Crecimiento en consumo de la TI

2011 marcará el punto en el que veremos desdibujarse las fronteras entre los dispositivos de consumo y los dispositivos empresariales. Lo vimos en 2010, con la entrada de los iPhones* y los teléfonos Droid* en las empresas. Los empleados querrán utilizar sus soluciones personales para la productividad en el trabajo y los empleadores querrán mejorar el ambiente corporativo con los dispositivos, para aumentar la productividad. La virtualización, la tecnología antirrobo, la administración remota y la seguridad traerán importantes aportes relacionados con esta tendencia.

Letreros inteligentes

Los letreros interactivos, como los de la película “Minority Report”, estarán ampliamente aceptados, incluyendo nuevos modos de interacción, como el reconocimiento de rostros y de gestos.

Revolución de los consumidores sobre energía y medio ambiente

Los consumidores pasarán de hablar sobre el manejo de su consumo de energía a controlarlo realmente con el lanzamiento de una variedad de dispositivos domésticos y servicios de manejo de la energía.

Tecnología para vehículos

Con tecnologías sofisticadas actuando como sistemas nerviosos centrales en los vehículos actuales, las nuevas tecnologías para vehículos están atrayendo un interés enorme, ya se trate de nuevas características de entretenimiento, del control por voz con manos libres de los teléfonos inteligentes, de otras tecnologías de seguridad o de funciones del conductor realizadas automáticamente por el vehículo.

Pronóstico soleado para el cómputo virtualizado en nube

La nube empresarial despegará a medida que más servicios basados en la nube se rediseñan para su uso comercial, incluyendo las redes sociales. Con la mayoría de las grandes corporaciones preparando la virtualización de sus respectivos entornos en 2010, el próximo año también verá el desarrollo de soluciones internas para la nube. Además, será posible realizar operaciones de renderización en la nube y distribuirlas a través de redes de banda ancha a dispositivos con poder gráfico modesto.

Visto en CXO Community

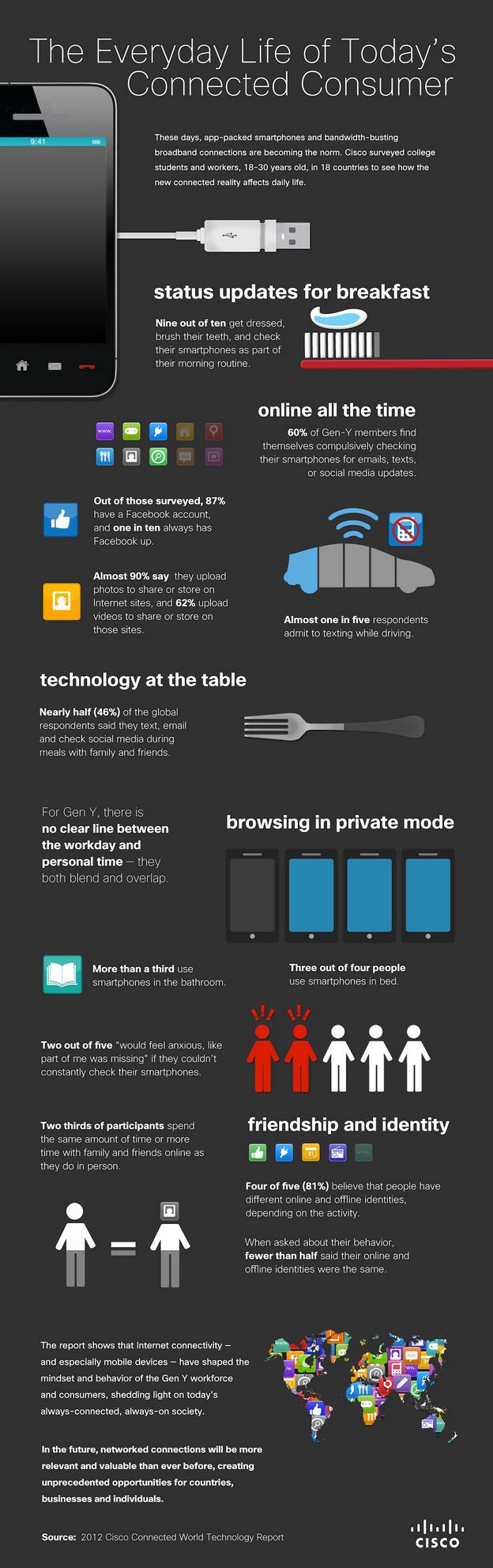

En sólo seis años los estudiantes chilenos se convirtieron en los protagonistas de la comunidad digital, ya que el 96% asegura conectarse a internet desde cualquier lugar y el 85% de ellos se siente un buen conocedor y experto en internet.

En sólo seis años los estudiantes chilenos se convirtieron en los protagonistas de la comunidad digital, ya que el 96% asegura conectarse a internet desde cualquier lugar y el 85% de ellos se siente un buen conocedor y experto en internet.

Además, están conectados los siete días de la semana y el chat es su principal medio de comunicación.

Los anteriores son sólo algunos de los principales resultados que arrojó la sexta versión del estudio “Índice Generación Digital (IGD)”, elaborado por VTR, en forma conjunta con Adimark GFK y Educarchile, que mide el avance de la digitalización de los estudiantes en el país desde el 2004 a la fecha.

“El principal cambio que vemos en estos seis años es el empoderamiento de los jóvenes con su conocimiento, tanto por el aumento en el acceso como por el aumento de la frecuencia de conexión y de uso”, señaló la directora ejecutiva de Adimark GFK, Verónica Edwards.

En materia de acceso, se observa que la tenencia de computador en el hogar aumentó de 46% a 74% en el periodo 2004-2009. Un 76% está conectado a internet entre los que tienen computador.

La conexión a internet desde el hogar pasó de 21% en 2004 a 56% en 2009, siendo los segmentos C3 y D los que mostraron las alzas más notorias.

Si bien, los estudiantes pertenecientes al grupo socioeconómico ABC1 tienen mayor acceso a internet, en estos seis años la brecha respecto del segmento D cae casi cinco veces.

Pese a este aumento del acceso desde el hogar, en promedio, el 53% de los estudiantes recurre a conectarse a los lugares públicos o pagados. Esta tendencia se viene mostrando desde el 2005 en adelante.

La frecuencia de conexión aumentó enormemente en seis años. Mientras en 2008 predominaban los usuarios Light (se conecta menos de 3 días a la semana) en un 35%, en 2009 pasaron a liderar los “heavy user” (se conectan 6 o 7 días por semana) representando el 40% de los usuarios.

Conocimiento y brecha padre e hijos

Otro importante hallazgo del estudio se refiere a la autopercepción que tienen los escolares de su conocimiento de internet.

Si en 2008 hubo un salto cualitativo en relación a 2004, pasando de 34% a 62% respectivamente, para el 2009, el 85% se califica de experto, es decir, más de 20 puntos en un año.

Frente a la pregunta de autopercepción de conocimientos en internet, los adultos respondieron que sólo un 31% se siente experto.

Si bien este porcentaje duplica al año 2008, cuando el 16% se declaraba experto, el avance de los hijos el 2009 acrecentó a un más la brecha de conocimiento.

En cuanto a los usos, los jóvenes utilizan la web para comunicarse, hacer tareas, buscar información de interés y entretenerse.

En este sentido, Windows Live Messenger figura como el principal medio de comunicación de los escolares. Sin embargo, gracias al avance de la Banda Ancha, que ha permitido el desarrollo de distintas plataformas sociales, los escolares están utilizando Facebook, MySpace, Youtube, entre otras.

A nivel escolar “el uso de las tecnologías en la escuela no “elimina” al docente, sino que le obliga a cambiar su rol para posibilitar más aprendizajes en niños y jóvenes”, explica el gerente del Area de Educación de Fundación Chile, José Weinstein.

A su juicio, “los resultados del IGD nos muestran que este nuevo rol del docente está todavía en ciernes y que ellos han incorporado algunos usos de las TICs como nuevos soportes. Sin embargo, se requiere incorporar nuevos modelos pedagógicos que muestren otros usos de estas tecnologías para un mayor aprendizaje”.

Seguridad en internet

Un aspecto importante es la seguridad que los jóvenes tienen al navegar. Se destaca que el “chateo” con desconocidos disminuyó del 47% al 43% entre 2008 y 2009.

Este dato confirma la curva descendiente iniciada en 2007 cuando alcanzaba el 74%.

También, aumentó el chateo con amigos, familiares y gente conocida. El mayor crecimiento lo experimentó el chateo con familiares que pasó de un 77% en 2008 a un 89% en 2009.

En tanto que, ingresar a páginas de pornografía (77%), tratar con adultos que se hacen pasar por niños (69%) y ser víctimas de ciberbullying (66%) son algunas de las conductas que los alumnos reconocen que se deben evitar para cuidarse en la red.

Visto en Emol

malware

McAfee, segundo fabricante mundial de software de seguridad, dijo que la producción de códigos conocidos como maliciosos, que pueden dañar computadores y robar contraseñas, alcanzó un nuevo máximo en los primeros seis meses del 2010.

La firma precisó que la producción total de códigos malignos continuaba creciendo y que estaban catalogadas 10 millones de nuevas piezas.

Por su parte el jefe de tecnología de Global Threat Intelligence de McAfee, Mike Gallagher, dijo que “nuestro último informe de amenazas muestra que el código maligno ha estado siguiendo una tendencia creciente durante la primera mitad del año 2010“.

McAfee también advirtió a los usuarios de computadoras Mac de Apple, hasta ahora consideradas relativamente seguras contra los virus, que podrían también ser objeto de códigos maliciosos en el futuro.

“Por varias razones, el código malicioso ha sido rara vez un problema para los usuarios de Mac. Pero esos días podrían acabar pronto“, dijo McAfee.

En abril, los laboratorios McAfee detectaron que el virus troyano enfocado a Mac conocido como “OSX/HellRTS”, que lee o modifica el contenido del portapapeles y juega con el usuario, por ejemplo, abriendo y cerrando el lector de CD.

“No queremos exagerar esta amenaza. Pero sirve de recordatorio que en esta era de cibercrimen, robo de datos e identidades, los usuarios de todos los sistemas y dispositivos deben tomar precauciones“, dijo McAfee.

Visto en Emol

Buscaron tambien:

Virus

Si ha sufrido de un ataque de virus. Tome algunos segundos para revisar el impacto inicial, pero solo algunos segundos. Una vez un virus esquiva las defensas de seguridad, rápidamente puede “romper” su sistema al destruir archivos, corromper información, dañar aplicaciones dejándolas inservibles, y en general causando un periodo sin actividad que puede ser costoso para la productividad.

Norton entrega los siguientes pasos para remover el virus y restablecer el sistema:

Desconecte y aísle:Piense en ello como poner el computador infectado en cuarentena. Si sospecha que un computador ha sido atacado por un virus, desconecte la máquina. Un equipo infectado puede poner en peligro otros computadores.

Límpielo: Una vez el computador haya sido desconectado, necesita remover el código malicioso. Utilice las herramientas de eliminación para virus específicos. Su software de antivirus debe tener actualizaciones o parches disponibles para la amenaza específica de seguridad. Si este software no ha sido actualizado de manera reciente, asegúrese de hacerlo.

Restablezca: Luego de ser atacado por un virus, los daños pueden variar desde el cambio de nombre de los archivos, la eliminación de los mismos, hasta inhabilitar de manera permanente aplicaciones de software. Antes de reanudar su trabajo, necesita restablecer su computador a su condición original.

Instale de nuevo: La extensión del daño depende del virus en particular. Si su sistema operativo está completamente destruido, necesitará instalarlo de nuevo. Para restablecer el equipo a su configuración original, utilice el CD de “restablecimiento rápido” que viene con su computador, esto significa que perderá cualquier aplicación que haya instalado o archivos de información que haya guardado. Antes de empezar el proceso de reinstalación, asegúrese de tener toda la información necesaria a la mano: software original, licencias, registro y números de serie.

Escanee para encontrar virus: Luego de restaurar y volver a instalar, escanee su red entera, incluyendo todos los archivos y documentos para encontrar virus. Utilice las definiciones de virus más recientes disponibles para su software de antivirus.

Restablezca su información: Este paso asume que usted ha sido aplicado y ha hecho copias de seguridad de sus archivos. Si no hace copias de seguridad con alguna periodicidad, sus archivos se perderán de manera permanente. Si ese es el caso, aprenda de su error y asegúrese de hacer copias de manera regular de ahora en adelante. Tenga en cuenta que no todos los virus tienen como objetivo los archivos de información, algunos atacan solo las aplicaciones.

Prevenga ataques futuros: Ejecute un software de antivirus y mantenga las definiciones de virus actualizadas. Asegúrese de que los parches de seguridad estén actualizados. Si perdió archivos con información en el ataque reciente, querrá crear y cumplir una programación periódica de copias de seguridad. El siguiente paso es cambiar todas las contraseñas incluyendo la del acceso al ISP, FTP, correo electrónico y sitios web. Algunos virus pueden capturar o descifrar contraseñas, permitiendo una futura vulnerabilidad. Cambie las contraseñas de inmediato.

Visto en Diario TI

Buscaron tambien:

Windows Update

En su ciclo habitual de actualizaciones los segundos martes de cada mes, Microsoft ha anunciado que en esta ocasión se esperan catorce boletines de seguridad. Afectan a toda la gama del sistema operativo Windows, Office y Silverlight. En principio, hablan de 34 vulnerabilidades.

Si en julio se publicaron cuatro boletines de seguridad, este mes ya se ha publicado uno fuera del ciclo habitual, además Microsoft prevé publicar catorce el próximo 10 de agosto. Ocho se consideran críticos (ejecución remota de código) y el resto importantes (elevación de privilegios o falsificación).

Adicionalmente, y como viene siendo habitual, Microsoft publicará una actualización para Microsoft Windows Malicious Software Removal Tool. Además, se publicarán actualizaciones de alta prioridad no relacionadas con la seguridad.

Uno de los boletines críticos está dedicado a Microsoft Silverlight 2 y 3. No se corregía ningún fallo de seguridad en Silverlight desde octubre de 2009.

Visto en Hispasec

Si, tal como se suele decir, los ojos son el espejo del alma, era de esperar que en algún momento se desarrollase una tecnología con la que desvelar todos sus secretos.

Si, tal como se suele decir, los ojos son el espejo del alma, era de esperar que en algún momento se desarrollase una tecnología con la que desvelar todos sus secretos.

Un grupo de investigadores de la Universidad de Utah, en Estados Unidos, ha sabido sacarle partido a los ojos para detectar en ellos, concretamente, la mentira. Los científicos han desarrollado una tecnología que rastrea los movimientos de los ojos para reconocer cuando alguien miente.

Las pruebas realizadas hasta el momento han demostrado una gran eficacia, por lo que este sistema podría convertirse en una prometedora alternativa al tradicional polígrafo, que se utiliza para registrar respuestas fisiológicas relacionadas con la acción de mentir, como las variaciones de la presión arterial, el ritmo cardíaco, la frecuencia respiratoria y la respuesta galvánica o conductancia de la piel, que se generan ante determinadas preguntas que se realizan al sujeto sometido a la prueba.

Mayor exactitud

El novedoso dispositivo servirá, en un futuro, de herramienta para reconocer la falsedad o la veracidad de las aseveraciones de delincuentes o detenidos, con una exactitud mayor de lo que hasta ahora se había logrado, aseguran los investigadores.

Según publica la Universidad de Utah en un comunicado, los autores del invento son los psicólogos John Kircher, Doug Hacker, Anne Cook, Dan Woltz y David Raskin, y su comercialización puede que no tarde mucho en llegar, dado que la licencia ha sido ya concedida a la compañía Credibility Assessment Technologies (CAT), con sede en Park City (Utah), publica la revista The Engineer.

Gerald Sanders, director de CAT, afirma que este método de rastreo ocular tiene un enorme potencial para aplicaciones de seguridad. El éxito de la tecnología ha sido fruto del trabajo que, durante años, han desarrollado Kircher y Raskin, éste último actualmente profesor emérito de la Universidad de Utah.

El rastreo ocular como medio de detección de mentiras se ha hecho una realidad en los últimos años gracias a avances sustanciales en la tecnología.

Entre los aportados por los investigadores de la Utah estarían el desarrollo y la evaluación de un programa informático específico y de los métodos para aplicar los tests oculares de manera eficiente.

Medición de las reacciones cognitivas

El uso de los movimientos oculares para detectar mentiras se diferencia de la prueba del polígrafo en que éste mide las reacciones emocionales de los individuos (que refleja la fisiología), mientras que la tecnología del rastreo ocular mide las reacciones cognitivas de la persona analizada.

Para realizar estas mediciones, los investigadores registran en el ordenador las reacciones oculares de cada sujeto sometido a la “prueba de la verdad”, mientras éste responde “verdadero” o “falso” a una serie de preguntas que se le realizan.

Además de registrar datos sobre el ojo y la dilatación de la pupila, el proceso también tiene en cuenta factores como el tiempo de respuesta, el tiempo de lectura y relectura y el número de errores del sujeto estudiado.

El esfuerzo no engaña

Los científicos determinaron inicialmente que mentir requiere de un esfuerzo mayor que decir la verdad, por lo que buscaron diversas indicaciones que señalasen dicho esfuerzo.

Por ejemplo, una persona que está siendo deshonesta tiene las pupilas más dilatadas y dedica más tiempo a leer y contestar las preguntas que se le hacen. Estas reacciones a menudo pasan casi inadvertidas, por lo que requieren de mediciones muy sofisticadas y de una modelización estadística específica que permitan determinar su significación.

Hasta ahora, según Kircher, los resultados obtenidos han sido muy importantes: el sistema ha demostrado ser igual o mejor que el polígrafo, y eso que aún sólo se encuentra en los primeros estadios de su perfeccionamiento.

Además de ser potencialmente más exacto que el polígrafo, este nuevo sistema presenta otros beneficios añadidos, aseguran los investigadores.

Por un lado, el rastreo ocular promete tener un coste sustancialmente menor. Además, requiere de sólo una quinta parte del tiempo que hoy se dedica a las pruebas de detección de mentiras, puede estar disponible en cualquier idioma y puede ser aplicado por técnicos corrientes, en lugar de por examinadores cualificados en el uso del polígrafo.

Detectar mentiras con eficacia

Las investigaciones en este método concreto se iniciaron hace cinco años, cuando los miembros del equipo empezaron a discutir sobre el concepto, de manera casual. Los investigadores nunca pensaron que llegarían a desarrollar a partir de esta conversación una tecnología puntera de detección de mentiras.

Aún queda trabajo por hacer, pero los científicos esperan que la licencia recientemente concedida les permita atraer fondos y potenciales clientes para poder seguir desarrollando su investigación.

Las agencias de seguridad, por ejemplo, podrían estar muy interesadas en este artefacto, puesto que suelen emplear el polígrafo para controlar regularmente a aquellos empleados en puestos especialmente sensibles, y siempre andan buscando maneras más efectivas de detectar las mentiras.

Visto en la Flecha

Buscaron tambien:

Kaspersky Lab ha patentado con éxito una tecnología innovadora en los EE.UU. que permite la estimación exacta del impacto potencial que una epidemia de malware puede tener, lo cual ayuda a detener su propagación.

Kaspersky Lab ha patentado con éxito una tecnología innovadora en los EE.UU. que permite la estimación exacta del impacto potencial que una epidemia de malware puede tener, lo cual ayuda a detener su propagación.

Una de las causas por las que un malware específico se extiende rápidamente por todo el mundo es porque se hace una detección en cada equipo en lugar de hacer un seguimiento general y determinar posibles epidemias. Lo que se necesita es un método que permita identificar fácilmente el origen de una epidemia y pueda estimar el grado y forma de propagación.

Esto es en resumen lo que permite hacer la tecnología de Kaspersky Lab, la cual ha sido recogida por la patente número 7743419 de la oficina de patentes y marcas de EE.UU el 22 de junio de 2010.

Esta tecnología funciona mediante el análisis de las estadísticas sobre amenazas informáticas, obtenidas de una red de vigilancia mundial. La red realiza un seguimiento del número de descargas de programas de malware, los ataques iniciados por los piratas informáticos, así como otros problemas de seguridad, registrando el tiempo cuando se producen, el origen y la localización geográfica.

Una epidemia se detecta en su fase inicial y su propagación se supervisa en tiempo y localización. Entonces, la seguridad y las medidas eficaces de protección puede ser efectuadas de manera oportuna.

La información ofrecida por la tecnología de Kaspersky Lab puede utilizarse por todos los países que se enfrentan a problemas de seguridad, y así iniciar la protección.

Visto en Blog Antivirus

Como era de esperar, dado que Microsoft suele alternar boletines con gran número de actualizaciones con boletines de poco contenido, el de esta semana será un boletín relativamente ligero, sobre todo, si se compara con el de junio, que incluyó 10 actualizaciones desarrolladas para parchear 34 vulnerabilidades.

Como era de esperar, dado que Microsoft suele alternar boletines con gran número de actualizaciones con boletines de poco contenido, el de esta semana será un boletín relativamente ligero, sobre todo, si se compara con el de junio, que incluyó 10 actualizaciones desarrolladas para parchear 34 vulnerabilidades.

Y aún hubiera sido más ligero si Tavis Ormandy, ingeniero de seguridad de Google, no hubiera obligado a la compañía a incluir el parche para una vulnerabilidad en el sistema Help and Support Center (Centro de Ayuda y Soporte) de Windows XP, al publicar el código de explotación para ésta brecha a principios de junio. Un fallo que, según ha informado la propia Microsoft, también afecta a Windows Server 2003.

Según Jerry Bryant, director de grupo en Microsoft Security Response Center, la compañía estaba en las fases preliminares de investigación sobre la vulnerabilidad cuando Ormandy hizo público su código de ataque el 9 de junio. Ormandy contactó con Microsoft para informarle del problema el 5 de junio y dos días después Microsoft le respondió que no discutiría sobre la fecha de emisión del parche hasta finales de esa semana.

“Nuestra intención era resolver la vulnerabilidad en el boletín de agosto, pero hemos acelerado los esfuerzos dado que los clientes estaban el peligro por la existencia de ataques activos”, señala Bryant. Y es que los hackers rápidamente empezaron a aprovechar la brecha lanzando ataques sólo cinco días después de que Ormandy hiciera código su exploit.

Microsoft aseguró la semana pasada haber detectado exploits contra esta vulnerabilidad lanzados contra más de 10.000 ordenadores desde el 15 de junio.

Visto en PC World

Prev1...678...14Next

Prev1...678...14Next  Page 7 of 14

Page 7 of 14

Hoy por hoy es una utopía que Linux vaya a desbancar al resto de sistemas operativos, especialmente a Windows, pero ¿te has preguntado alguna vez qué sucedería si se llegara a producir la adopción generalizada de Linux?

Hoy por hoy es una utopía que Linux vaya a desbancar al resto de sistemas operativos, especialmente a Windows, pero ¿te has preguntado alguna vez qué sucedería si se llegara a producir la adopción generalizada de Linux?